언어모델

- 자연언어 (Natural Language)

- 인간의 언어

- 정보전달의 수단이자 인간 고유의 능력으로 인공언어에 대응되는 개념 - 언어모델 (Language Model) = 지식 표현 체계

- 언어를 이루는 구성 요소(글자, 형태소, 단어, 단어열(문장), 문단 등)에 확률값을 부여하여 이를 바탕으로 다음 구성 요소를 예측하거나 생성하는 모델

- 단어 시퀀스에 확률을 할당(assign)

=> 언어모델은 가장 자연스러운 단어 시퀀스를 찾거나 문맥 정보를 이해하는 모델

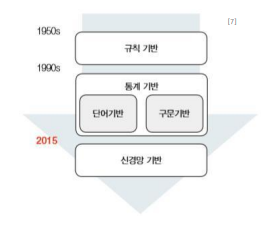

언어모델의 종류 및 특징

- 언어모델의 역사

- 규칙기반 언어모델

- 언어의 문법적 규칙을 사전에 정의하고 이에 기반하여 자연어를 처리

- 초창기에 사용한 연구방법

- 어순이 정형화되어 있지 않은 경우 분석에 한계가 존재

- 규칙의 사전 지정은 큰 부담. 작업의 정확도 또한 낮음 - 통계기반 언어모델

- 통계적 언어 모델은 단어열이 가지는 확률 분포를 기반으로 각 단어의 조합을 예측하는 전통적인 언어 모델

=> 실제로 많이 사용하는 단어열(문장)의 분포를 정확하게 근사하는 것

- 주어진 단어를 바탕으로 다음 단어로 올 확률이 가장 높은 단어를 예측하는 일련의 과정을 의미

=> 언어 현상에 조건부 확률 적용 - 딥러닝기반 언어모델

- 퍼셉트론을 기반으로한 인공 신경망 설계를 통해 단어의 의미적 유사성을 학습할 수 있도록 설계

=> ‘문맥’을 반영. 기존의 희소성 문제를 완화

- 학습 코퍼스에 없어도, 문맥을 참고하여 보다 정확한 예측

- 피드 포워드 신경망 -> 순환 신경망 -> Transformer

- A Brief Timeline of NLP : Transformer Family

- 영향력 : Transformer의 등장 이후로 NLP연구의 메인 트렌드

- Encoder만 사용하는 BERT family

- Decoder만 사용하는 GPT family

- Encoder-Decoder(Seq2Seq)구조를 가지는 BART family, Transformer-XL family 등

Encoder vs Decoder

- Encoder

- 각 stage에 어텐션 레이어가 초기 문장의 모든 단어에 접근 가능

=> Encoder 모델은 전체 문장의 이해를 요구하는 task에 가장 적합

- BERT (Bidirectional Encoder Representations from Transformers)

- Contextual Embedding

- Masked Language Modeling(MLM): 마스킹된 토큰을 예측

- Next Sentence Prediction(NSP): 문장이 다른 문장과 이어질 확률을 예측

- RoBERTa (Robustly optimized BERT approach)

- 더 긴 시퀀스, 많은 훈련 데이터로 더 큰 배치에서 오래 학습

- NSP 없이 Dynamic Masking 적용 => 성능이 크게 향상 - Decoder

- 각 stage에서 문장 내에서 주어진 단어의 앞쪽만 접근가능

=> Decoder 모델은 텍스트 생성과 관련 task에 가장 적합

- GPT (Generative Pre-trained Transformer)

- Auto-Regressive

- 주어진 Input을 기반으로 다음에 올 토큰을 예측

=> 시퀀스의 한쪽만 참고

- 추가적인 fine tuning 없이도 자체적으로 충분히 좋은 성능

=> Few-shot / Zero-shot의 등장 - Sequence-to-Sequence의 대표적인 모델

- BART (Bidirectional Auto-Regressive Transformer)

- Encoder와 Decoder를 모두 사용한 사전학습 모델

- Encoder에서 input을 입력 받아 표현형 벡터로 변환

=> Decoder에서 해당 벡터를 기반으로 다음 토큰을 생성

- 5가지 Denoising technique을 사용해 self-supervised learning으로 사전 학습

- T5 (Text-to-Text Transfer Transformer)

- Text-to-text problem: input으로 text를 받아서, output으로 새로운 text를 생성하는 문제

- 다양한 text processing problem ⇒ Text-to-text 문제로 변형

- Pre-training T5

- Span 단위의 Masking(Replace corrupted spans)을 통해 원래 텍스트를 순차적으로 복구하는 것으로 pre-training

- Pre-training dataset과 unsupervised task로 변환된 downstream task들의 dataset을 섞어, 한번에 학습하는 Multi-task Pre-training을 사용함

- Using T5 for Closed-book QA

- Fine-tuning T5: 미리 학습된 pre-trained T5를 활용

- MRC 데이터셋 (TriviaQA, WebQuestions, Natural Questions) 의 QA pair를 활용

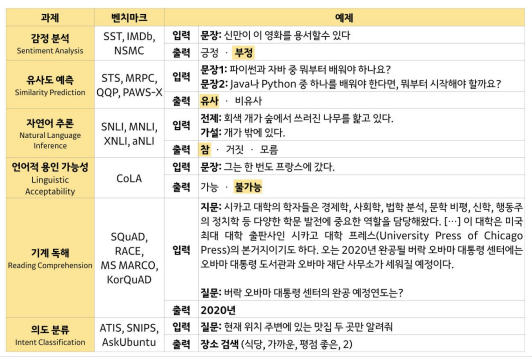

자연언어처리속 일반적인 Task 관점에서 언어모델의 역할

- NLU

- 자연어를 기계가 이해할 수 있는 형태로 변환하는 자연어 처리 기술의 분야

- 지금까지 대부분의 연구 NLU에 집중되어있음

- NLU Task

- NLG

- 시스템 계산 결과를 자연어로 자동으로 생성하는 자연어 처리 기술분야

- NLG Task

- NLU with NLG

- 기계 번역 - 좋은 언어표상능력을 각각의 Task로 전이

- LLM의 등장

- From Language Model to Large Language Model

- 대부분의 기존 Task에서 LLM(Large Language Model)은 월등히 높은 성능을 달성

- 기존의 일반적인 benchmark들은 LLM의 내재적 능력을 파악하기에는 부적합

=> 일반적으로 널리 쓰이던 benchmark로부터 탈피

=> 더욱 challenge, hard, human-like 한 Task와 Dataset이 필요

자연언어처리속 Application 관점에서 언어모델의 역할

- 기계번역

- NLP Application - Universal Speech Model

- "1,000개 언어 이니셔티브(1000개 언어를 지원하는 머신러닝 모델 만들기)"를 진행

- USM은 2B(20억)개의 파라미터로 300개가 넘는 언어, 1200만 시간의 음성, 280억개의 문장으로 훈련됨

- 유튜브에서 자막 생성을 위해 사용

- 영어/중국어뿐만 아니라, Amharic, Cebuano, Assamese, Azerbaijani 같은 언어까지 지원 - Grammatical Error Correction

- Meeting Summarization

- 클로바 - Writing Assistant

- 음성인식

- AI Assistant

- 시리, 빅스비, 클로바, 구글 어시스턴스, 지니 등등 - OpenAI Whisper

- Text to Image Generation

- DALLE2 - Presentation Tools

- Code Generation

- cusor - 검색 엔진

- Personalized ChatBot

- Domain specialized Q&A system

- Recommendation System

'Study > 자연언어처리 NLP' 카테고리의 다른 글

| 카운트 기반 언어모델 (0) | 2025.02.03 |

|---|---|

| 전통적인 언어 지식 표현 체계 (0) | 2025.02.03 |

| NLP 대회 전략 (0) | 2025.01.17 |

| BERT 이후의 모델 (1) | 2025.01.17 |

| Encoder-Decoder Model (BART) (1) | 2025.01.17 |